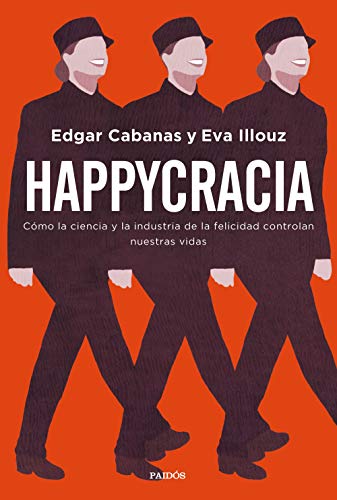

Existe una tendencia, cada vez más aplastante, de convertir las empresas (y la sociedad en general) en una suerte de dictadura de la felicidad. Se parte de la base de que la felicidad es el único estado valioso para la persona, se censura cualquier expresión de descontento y, en general, se busca que la solución al malestar sea rápida y efectiva. Ya sea una pastilla o un bien de consumo, hay que eludir la tristeza o la rabia. Dos fantásticos ensayos, Sonríe o Muere (Barbara Ehrenreich) y Happycracia (Edgar Cabanas y Eva Illouz) lo fundamentan desde dos enfoques distintos. El primero profundiza en los mecanismos de inhibición social (como la idea aberrante de las personas tóxicas) y el segundo es un torpedo en la línea de la flotación de la psicología positiva, la (seudo)ciencia de la felicidad. Les recomiendo que si el tema les interesa les echen una buena ojeada, porque yo voy a apoyarme en ambos para hablarles de Eliza.

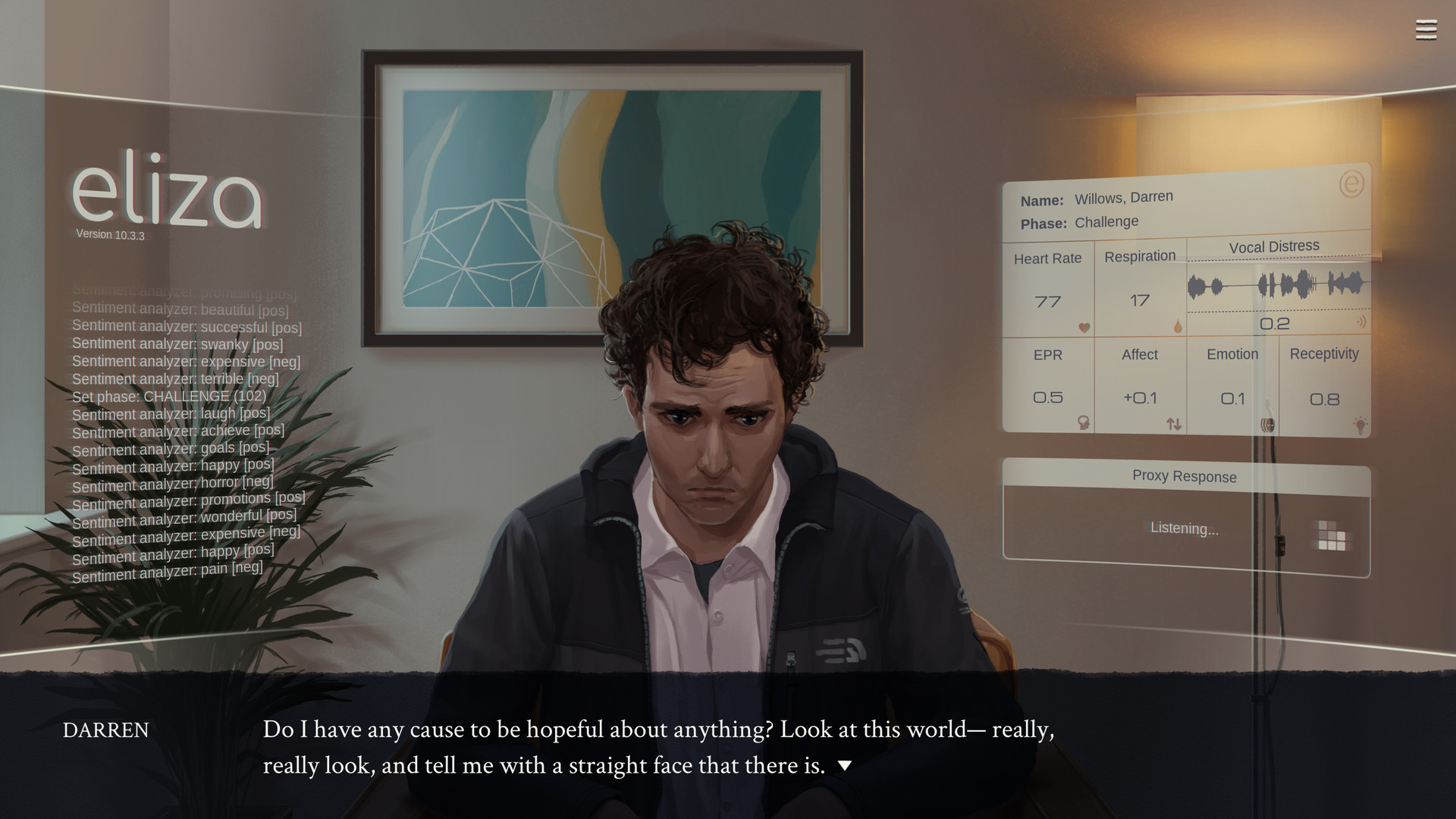

El videojuego de Zachtronics es una visual novel que nos traslada a un Seattle del futuro cercano en el que las apps de autocuidado (peligroso y muy tergiversable concepto) han llegado a un nivel mayor de refinamiento. Al fin y al cabo es el proceso lógico: si codificamos el ejercicio que hacemos y las calorías que comemos, ¿por qué no darle a las empresas la intimidad de nuestra salud mental? Lo último en el mercado es una herramienta llamada Eliza, que apoyándose en la app de bienestar de la compañía fundadora, promete revolucionar la salud mental. Para ello cuenta con una sofisticada base de datos, casi una inteligencia artificial, que actuará como “asesoría psicológica” (counseling en el original). Eliza actúa como un chatbot sumamente avanzado, escuchando al usuario y emitiendo una serie de preguntas para descubrir el origen de su malestar y emitir luego un “tratamiento”. Aunque al usuario se le deja claro que ante casos graves hay que acudir a un profesional, lo cierto es que Eliza acaba convirtiéndose en el tratamiento de un sector de la población: los que no pueden pagarse un profesional cualificado. El éxito de la herramienta es posible por una decisión de diseño muy relevante: es otro ser humano el que emite las preguntas de la IA, un proxy que entrevista al paciente en una sala tranquila con unas gafas de realidad aumentada que le dicen, continuamente, lo que debe decir. Y, para mejorarlo, este tentáculo de Eliza es un trabajador de la gig economy al que evaluarán, tendrá propinas y podrá ser expulsado del sistema si se sale del guión. Trabajadores pobres atendiendo como marionetas de un chatbot a otros trabajadores pobres.

El videojuego de Zachtronics es una visual novel que nos traslada a un Seattle del futuro cercano en el que las apps de autocuidado (peligroso y muy tergiversable concepto) han llegado a un nivel mayor de refinamiento. Al fin y al cabo es el proceso lógico: si codificamos el ejercicio que hacemos y las calorías que comemos, ¿por qué no darle a las empresas la intimidad de nuestra salud mental? Lo último en el mercado es una herramienta llamada Eliza, que apoyándose en la app de bienestar de la compañía fundadora, promete revolucionar la salud mental. Para ello cuenta con una sofisticada base de datos, casi una inteligencia artificial, que actuará como “asesoría psicológica” (counseling en el original). Eliza actúa como un chatbot sumamente avanzado, escuchando al usuario y emitiendo una serie de preguntas para descubrir el origen de su malestar y emitir luego un “tratamiento”. Aunque al usuario se le deja claro que ante casos graves hay que acudir a un profesional, lo cierto es que Eliza acaba convirtiéndose en el tratamiento de un sector de la población: los que no pueden pagarse un profesional cualificado. El éxito de la herramienta es posible por una decisión de diseño muy relevante: es otro ser humano el que emite las preguntas de la IA, un proxy que entrevista al paciente en una sala tranquila con unas gafas de realidad aumentada que le dicen, continuamente, lo que debe decir. Y, para mejorarlo, este tentáculo de Eliza es un trabajador de la gig economy al que evaluarán, tendrá propinas y podrá ser expulsado del sistema si se sale del guión. Trabajadores pobres atendiendo como marionetas de un chatbot a otros trabajadores pobres.

Empezamos a jugar y encarnamos a Evelyn, una protagonista que tiene un papel más importante del que pudiera parecer en un principio. Hemos empezado a trabajar como proxys de Eliza y ya con el primer paciente descubriremos lo obtuso del funcionamiento de la máquina. A la vez que extrae datos personales de sus usuarios, básicamente se limita a repetir la misma entrevista semiestructurada y a llegar a dos recetas para curar la infelicidad: instálate una app de la compañía que te ayudará a relajarte y pídele tal o cual medicamento a tu médico. Es el futuro pero ya es nuestro presente, si uno atiende a los dos ensayos mencionados: consume para quitarte la tristeza, no pienses, sigue adelante, produce. Esto está escrito de manera tan clara en Eliza que hasta duele, con todo el mundo alabando la app aunque no sirva para nada, con los usuarios enganchados al ciclo de ir a contar su vida para sentir que alguien les hace caso y sin nadie que le plante cara a lo inútil de todo el sistema.

Empezamos a jugar y encarnamos a Evelyn, una protagonista que tiene un papel más importante del que pudiera parecer en un principio. Hemos empezado a trabajar como proxys de Eliza y ya con el primer paciente descubriremos lo obtuso del funcionamiento de la máquina. A la vez que extrae datos personales de sus usuarios, básicamente se limita a repetir la misma entrevista semiestructurada y a llegar a dos recetas para curar la infelicidad: instálate una app de la compañía que te ayudará a relajarte y pídele tal o cual medicamento a tu médico. Es el futuro pero ya es nuestro presente, si uno atiende a los dos ensayos mencionados: consume para quitarte la tristeza, no pienses, sigue adelante, produce. Esto está escrito de manera tan clara en Eliza que hasta duele, con todo el mundo alabando la app aunque no sirva para nada, con los usuarios enganchados al ciclo de ir a contar su vida para sentir que alguien les hace caso y sin nadie que le plante cara a lo inútil de todo el sistema.

El peso de la trama del juego se estructura entre las sesiones usando la herramienta y la propia historia personal de Evelyn, su pasado y relación real con Eliza y las personas que la rodean. Varios caminos se nos abren y tenemos la posibilidad de elegir lo que nos parezca, sin que el título nos lleve de la mano o nos dé su opinión sobre lo que está pasando. Por cómo está escrito parece obvio que no es una defensa del sistema actual, pero nuestras serán las conclusiones. Por el camino se adentra en más arenas movedizas: la posibilidad de la creación de una IA real por parte de una empresa, una extraña mezcla de psicoanálisis y neuropsicología como camino para eliminar para siempre la tristeza (y las implicaciones filosóficas de esto) y la desmesurada extracción de datos violando la privacidad de gente que se presta voluntaria a ello. Hay todo un cóctel ideológico aquí, y aunque es el jugador el que decide, no creo que se pueda acusar a sus creadores de no posicionarse.

Al contrario, la tesis está bien clara: nos encaminamos a un mundo en el que estaremos cada vez más solos. Tan solos que casi consideraremos terapéutico charlar con una máquina que apenas nos entiende y cuya solución para todo es una versión del “no estés mal” que incluye algo de química para que no molestemos al sistema. Ahora que se habla mucho de videojuegos empáticos, de videojuegos que promueven la salud mental o quieren acercarnos a las personas que sufren a través de su experiencia, Eliza nos recuerda la importancia del factor humano. Nos pide que no nos flipemos demasiado por mucho que prometa la realidad virtual en temas como el tratamiento psicológico y que no dejemos que nuestra dignidad humana se mida en torno a lo productivos que seamos. Porque para la inteligencia que hay tras Eliza y el resto de entidades capitalistas nuestra felicidad es una cualidad medible y aprovechable, a la altura de hablar un idioma extranjero o saber programar. Si no la tenemos no somos valiosos, no somos un producto que ellos puedan comprar por un salario exiguo y luego utilizar. Enfádense y denle las gracias al juego por el aviso.

Al contrario, la tesis está bien clara: nos encaminamos a un mundo en el que estaremos cada vez más solos. Tan solos que casi consideraremos terapéutico charlar con una máquina que apenas nos entiende y cuya solución para todo es una versión del “no estés mal” que incluye algo de química para que no molestemos al sistema. Ahora que se habla mucho de videojuegos empáticos, de videojuegos que promueven la salud mental o quieren acercarnos a las personas que sufren a través de su experiencia, Eliza nos recuerda la importancia del factor humano. Nos pide que no nos flipemos demasiado por mucho que prometa la realidad virtual en temas como el tratamiento psicológico y que no dejemos que nuestra dignidad humana se mida en torno a lo productivos que seamos. Porque para la inteligencia que hay tras Eliza y el resto de entidades capitalistas nuestra felicidad es una cualidad medible y aprovechable, a la altura de hablar un idioma extranjero o saber programar. Si no la tenemos no somos valiosos, no somos un producto que ellos puedan comprar por un salario exiguo y luego utilizar. Enfádense y denle las gracias al juego por el aviso.